최소제곱법의 결정적인 문제점(약점) 두가지

1) 예측 정확도 : 편향은 낮지만 분산은 높게 추정하는 경우가 있음(불안정한 모델이 만들어지는 경우가 있음)

편향이 낮다 = 적합도가 높다

분산이 높다 = 모집단에서 어떤 데이터를 샘플링해서 회귀분석을 하느냐에 따라서 추정되는 모수값이 크게 달라진다

2) 설명력

가장 좋은 효과를 보이는 매우 작은 서브셋은 설명력을 저하시킨다

서브셋

여러개의 독립변수를 포함하는 경우/포함하지 않는 경우 두가지 경우를 모두 고려한 data set

k개의 독립변수가 있다면 (2^k-1) 개의 subset 존재 (모든 독립변수 사용하지 않는 경우를 제외)

최적 서브셋 회귀

(오차)^2 의 합을 최소화하는 서브셋을 구하는 과정

회귀분석에서의 변수 선택

Extra Sum of Squares : 회귀분석 모형에 변수가 추가된 경우 SSR 의 증가분

SSR = 회귀분석의 설명력

SSR의 증가분 = SSE의 감소분

* SSR(회귀변동) : 회귀분석을 통해 설명할 수 있는 y값의 변동

* SSE(잔차변동) : 회귀분석을 통해 설명할 수 없는 y값의 변동

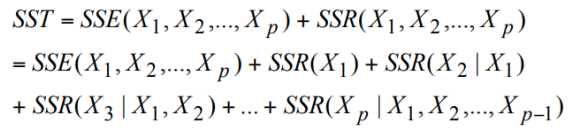

* SST(총변동) = SSR + SSE

X2 라는 변수가 존재하고, X1이 추가되었을 때 SSR의 증가분

= (X1과 X2가 동시에 존재할때 회귀분석의 설명력) - (X2만 존재할때 회귀분석의 설명력)

= (X2만 존재할때 오차) - (X1과 X2 가 존재할 때 오차)

오차가 작아지는 정도가 크면(SSE의 감소분이 크면) 해당 변수를 추가해야 하고

오차가 작아지는 정도가 미미하면(SSE의 감소분이 미미하면) 해당 변수를 추가할 이유가 없다

변수를 제외했을 때

오차가 변화량이 미미하면 해당 변수를 제외해야하고 (모델을 단순화할수있으므로)

오차가 오차 변화량이 크면 해당 변수를 제외할 수 없다

오차의 변화가 통계적으로 유의 ?

변수를 추가한 경우 : 변화가 유의해야 추가

변수를 제거한 경우 : 변화가 유의하지 않아야 제거

SSE f : 모든 변수를 사용했을 때의 오차

SSE r : 변수를 줄였을때의 오차

'School > 머신러닝' 카테고리의 다른 글

| 선형분류 (0) | 2022.04.06 |

|---|---|

| 과적합과 과소적합 (0) | 2022.03.30 |

| 회귀분석에서의 변수선택 (0) | 2022.03.30 |

| 다중회귀모형의 선택 (0) | 2022.03.29 |

| 다중공선성 (0) | 2022.03.29 |